昨天千问发布了最新的Qwen3-4b-Instruct-2507 和Qwen3-4b-Thinking-2507 模型,有如下两个亮点:

- Qwen3-4B-Instruct-2507 的通用能力超越了商业闭源的小尺寸模型 GPT-4.1-nano,与中等规模的 Qwen3-30B-A3B(non-thinking)性能接近。

- Qwen3-4B-Thinking-2507 的推理表现可媲美中等模型 Qwen3-30B-Thinking,在聚焦数学能力的 AIME25 测评中以4B参数获81.3分;且通用能力相关评测均超越了更大尺寸的Qwen3-30B-Thinking模型。

我所用设备为红米Note12T Pro (联发科天玑8200-Ultra + 12G RAM + 512G ROM),在手机上运行这两个模型,居然还能不错。

因此有本文简单介绍如何在Android设备上使用mnn chat本地部署和运行 Qwen3-4b-Instruct-2507 和Qwen3-4b-Thinking-2507 模型。

安装应用

最新版本请访问阿里巴巴的MNN项目下的Android应用页面获取安装包

也可以直接访问阿里巴巴官方CDN的下载链接 https://meta.alicdn.com/data/mnn/mnn_chat_0_6_8.apk下载安装包。

或者也可以尝试在应用市场中搜索,Play Store 里面是有的,其他的应用商店或许也有。

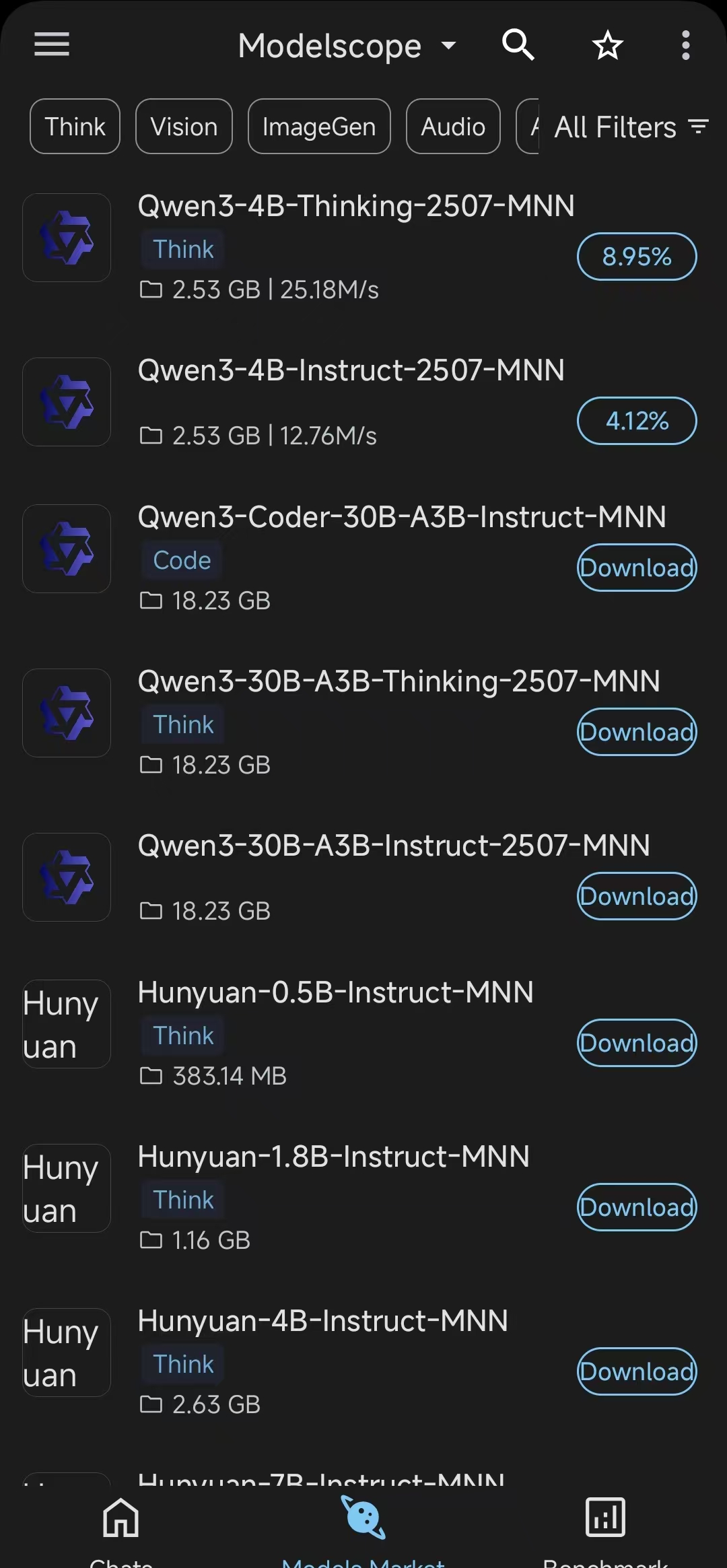

下载模型

打开 mnn chat,在顶部将下载源从huggingface切换成modelscope,然后,选择 Qwen3-4b-Instruct-2507 或者 Qwen3-4b-Thinking-2507 模型,就可以下载到本地了。

看尺寸应该是q4量化的?

测试性能

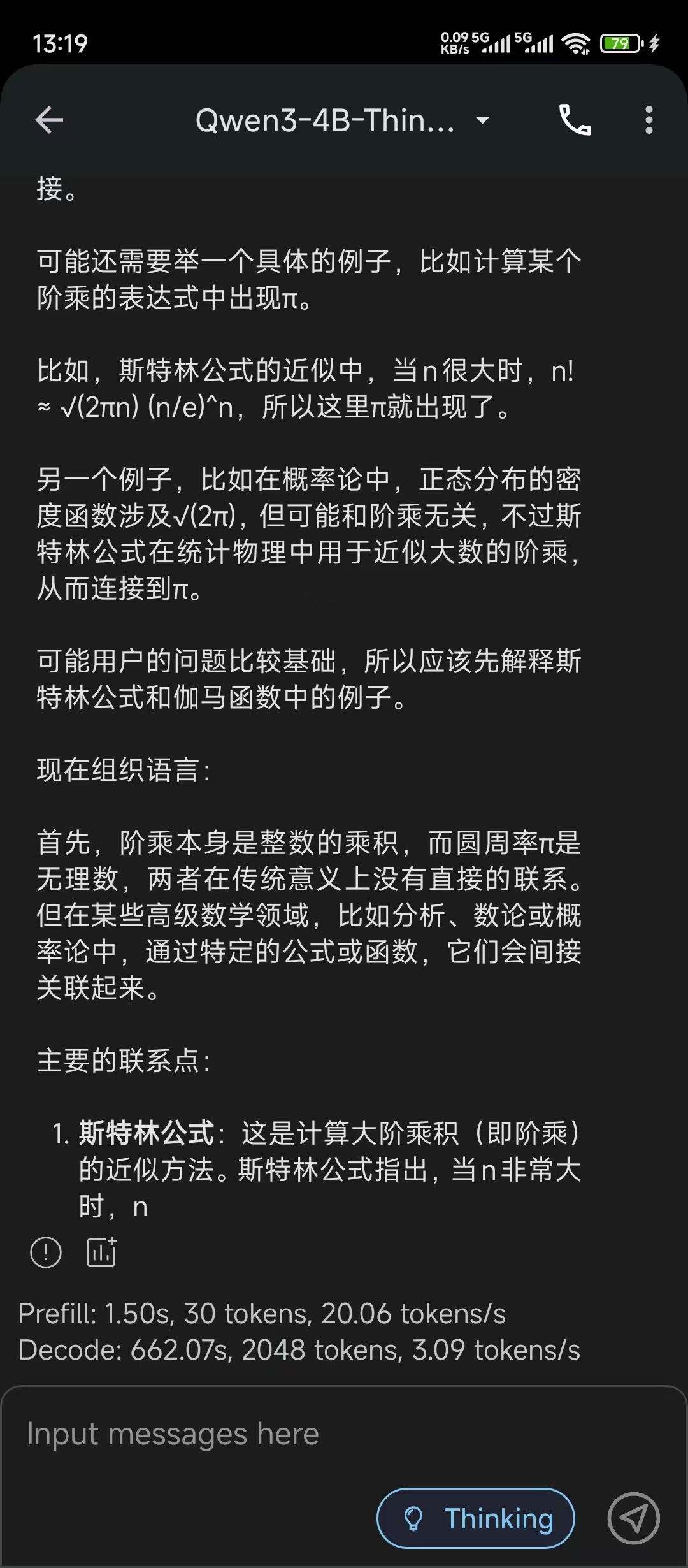

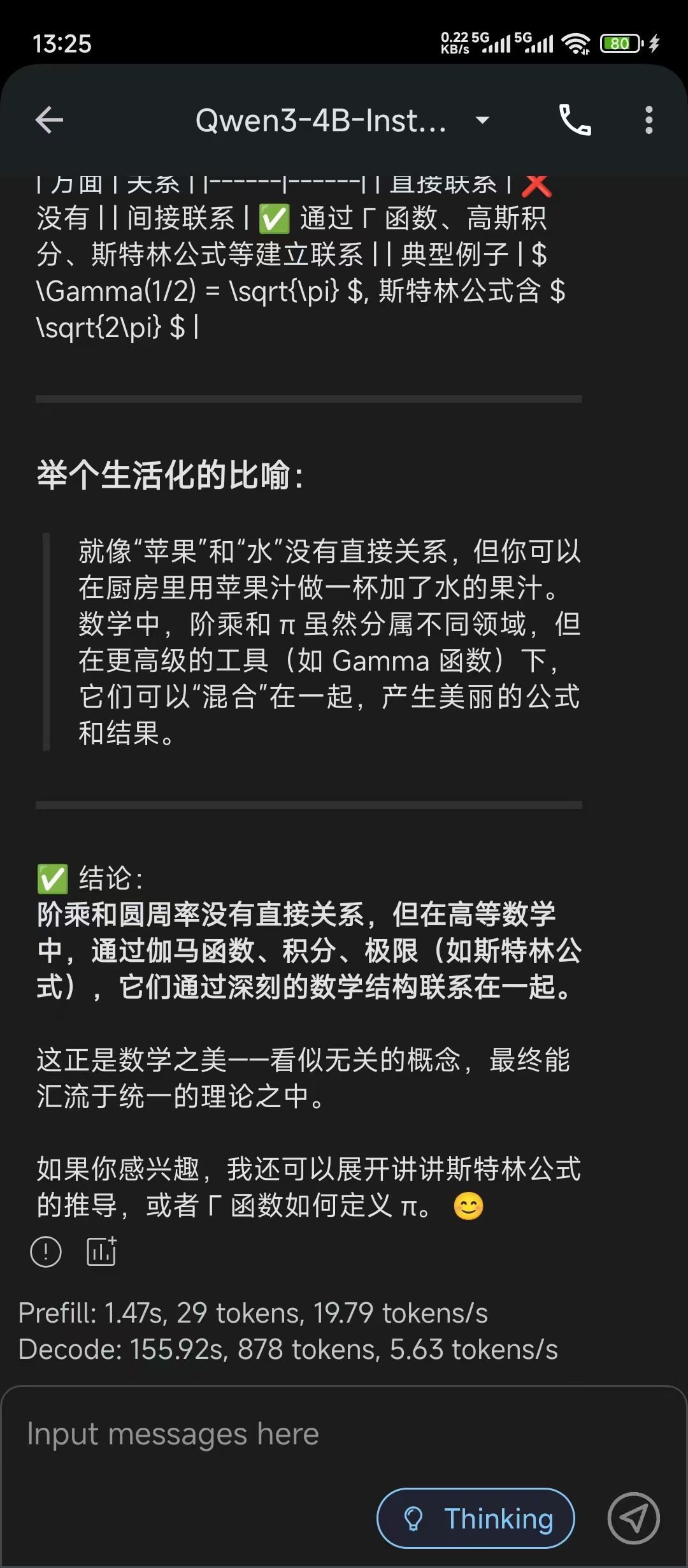

用了一个简单的问题“阶乘和圆周率有什么关系”测试了一下,所用设备为红米Note12T Pro (联发科天玑8200-Ultra + 12G RAM + 512G ROM)。

Qwen3-4b-Thinking-2507 模型能达到约 3 tokens/s。

Qwen3-4b-Instruct-2507 模型能达到约 5 tokens/s。

阿里巴巴的 MNN 框架速度确实不错,感觉比 llama.cpp 要快不少好像。 虽然 3-5 tokens/s 的速度绝对不算快,也足够日常的离线场景简单应急了。

CycleUser

CycleUser