一直以来,我都痴迷于本地模型。

一方面是我所在地区的网速实在不理想,另一方面是我不太信任云服务。

最近好像有个消息,有一位开发者过于信任自己参与贡献过的某个业内知名的云服务提供商,结果多年的数据都没了。

前一段时间好像是什么考试期间,某些模型服务商也限制了访问和使用。

我就特别讨厌被这种事情影响,所以一直执着于本地布置模型来运行。

VS Code搭配Cline的体验实在是感觉一般。而Cursor的本地模型支持太麻烦,需要自己实现一个openai的api,而且还需要自己实现一个web服务。Trae的本地模型我也没弄明白。

直到后来发现了一个开源项目,叫Void,可以直接用ollama运行本地模型,而且开源免费,堪称本地化Cursor平替。

开源地址:https://github.com/voideditor/void 官方网站:https://voideditor.com/

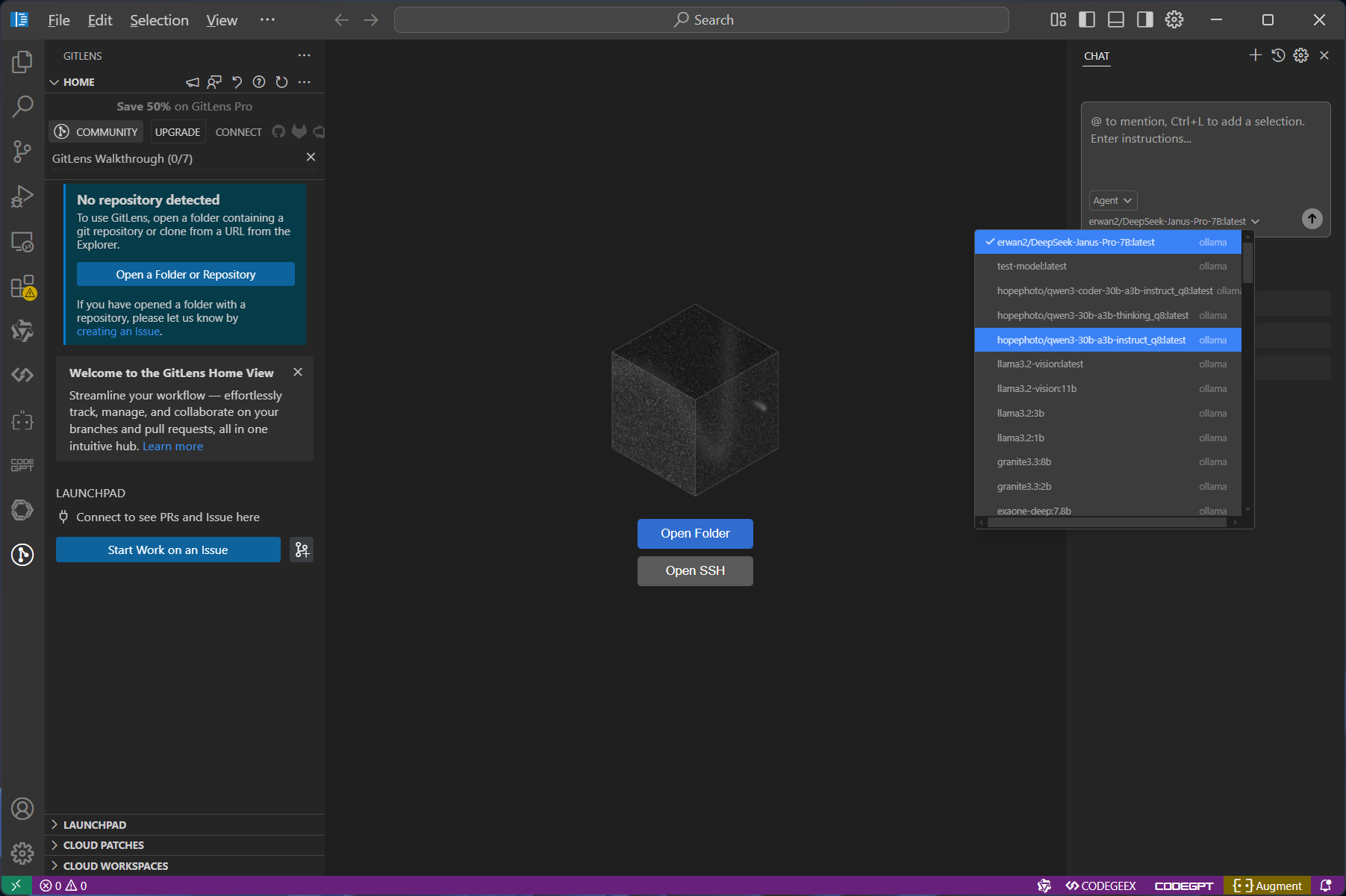

Void和之前推荐给同学们的VS Codium类似,也是VS Code的一个开源版本,然后按照类似Cursor的风格做了设计,左侧是主窗口,右侧是类似Cursor的对话窗口,可以选择Ollama的本地模型,也可以选择云端的模型。

- 获取安装包

Void的安装方式很简单,对于Windows 11用户来说,还可以使用 winget 安装:

winget install void

另外还可以直接去官网的下载页面 https://voideditor.com/download-beta 下载安装包,然后双击安装即可;也可以在Void的GitHub页面上下载。

Void官网提供的安装包支持Windows和macOS,amd64 和 arm64 系统都有支持。

不过考虑到网络访问的问题,我将 Windows的安装包上传到了百度网盘,大家也可以直接下载安装。

链接: https://pan.baidu.com/s/1rLbiRPjSZsaKa9rnK5E7GQ?pwd=CUGB 提取码: CUGB

- 安装过程

我用的是Winget的安装方法,安装完成之后,从开始菜单找到Void的快捷方式,点击运行,就出现了主界面。

主界面有 Free、Paid、Local、Cloud/Other 四个选项,其中 Free 是免费版,Paid 是付费版,Local 是本地模型,Cloud/Other 是云端模型。

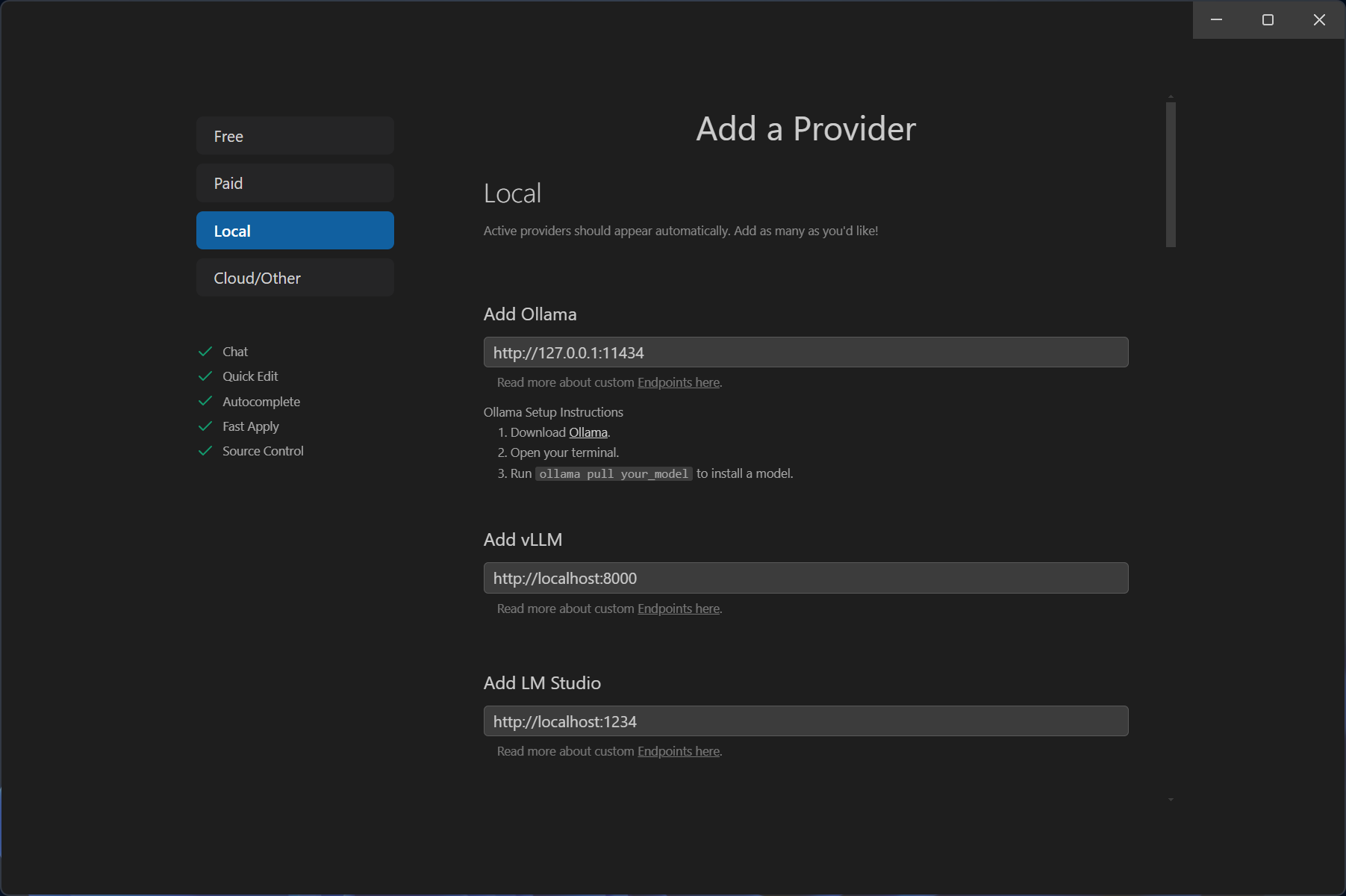

我要用本地模型,就选择Local,如下图所示,Ollama、vLLM、LM Studio都是支持的,我习惯用前者了。

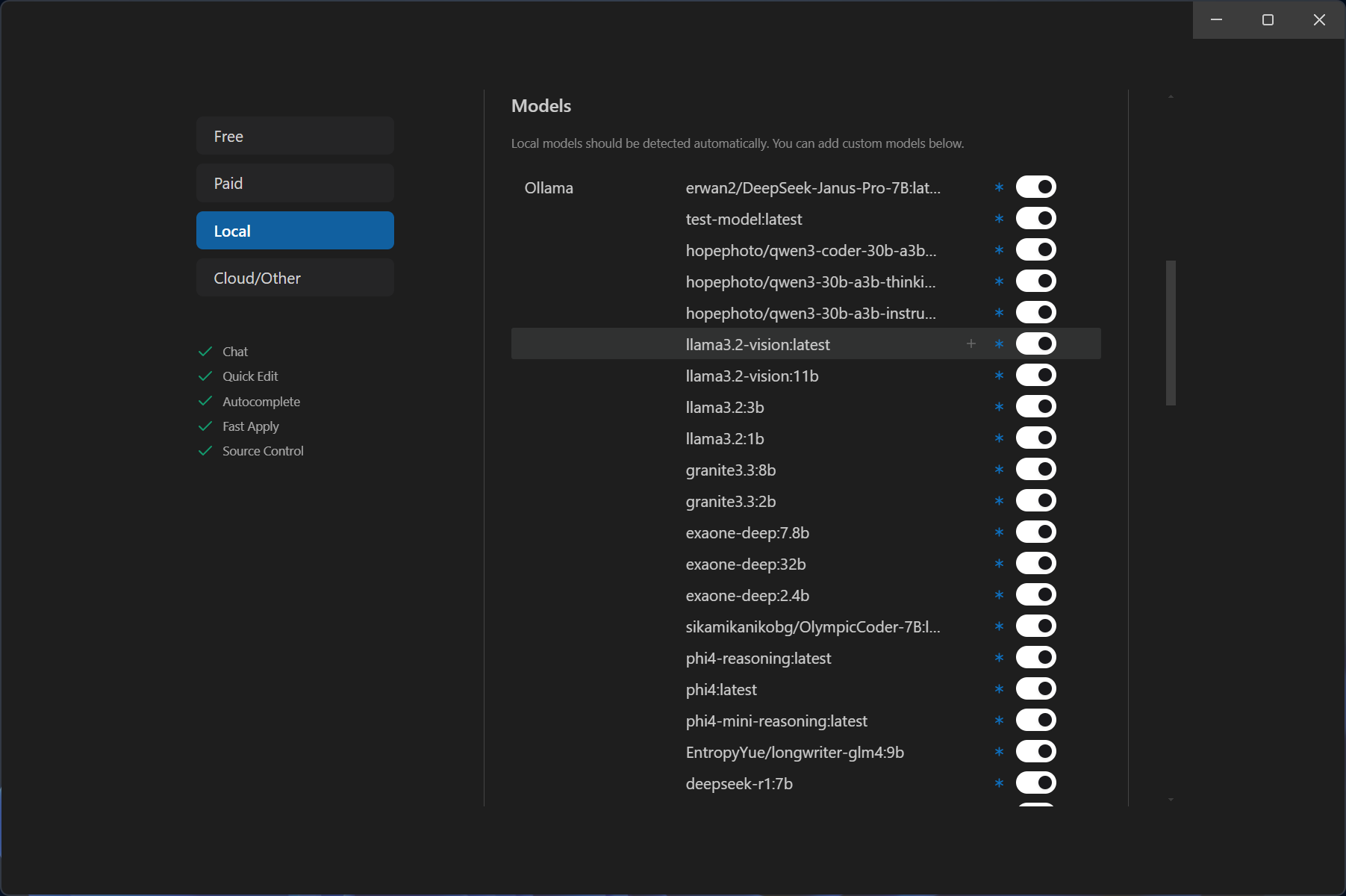

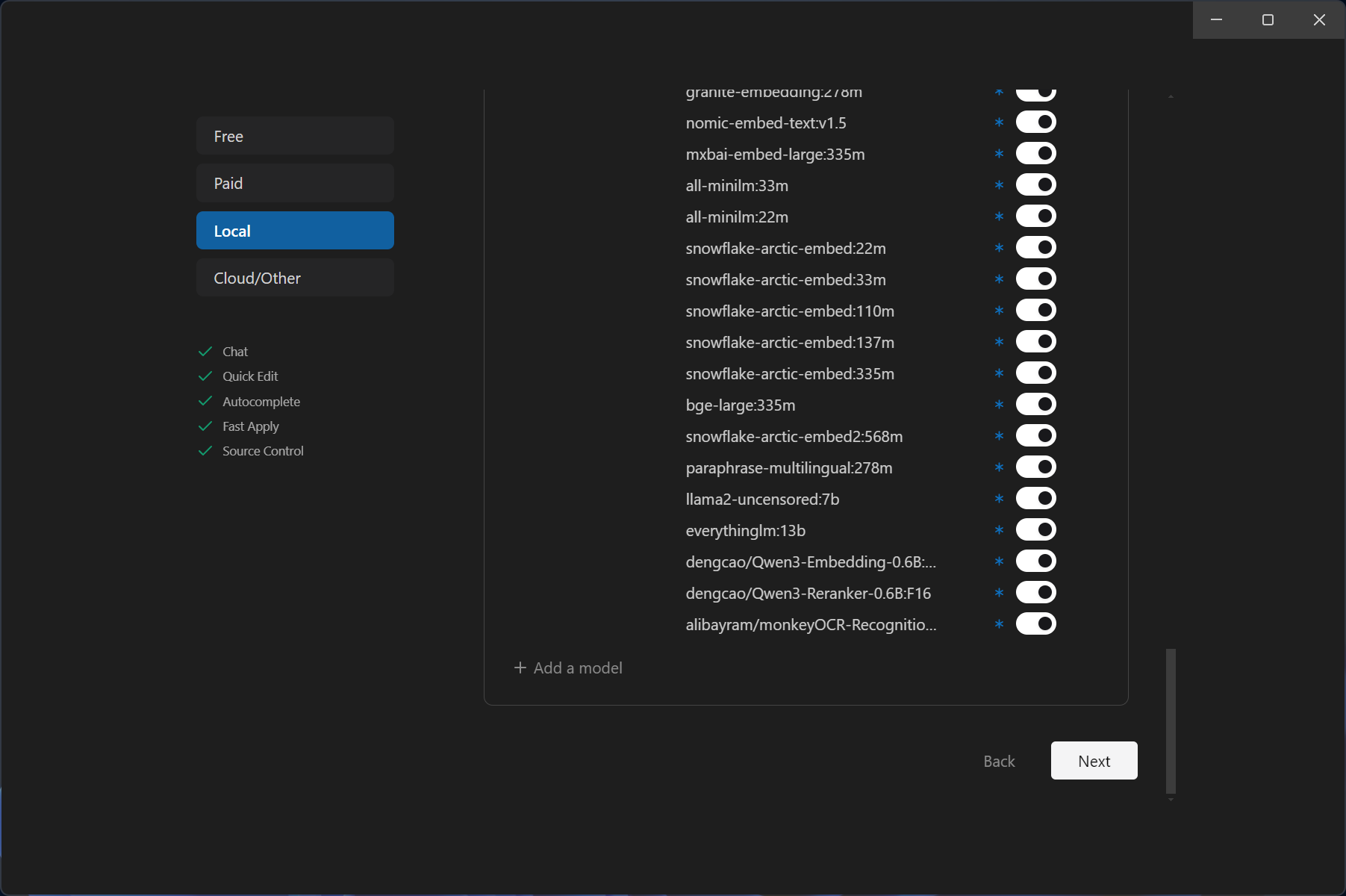

往下滚动,会看到本地已经安装好的Ollama的模型都被识别出来了,默认都可以启用了。

确定了自己要用的模型都能用,就点击Next继续了。

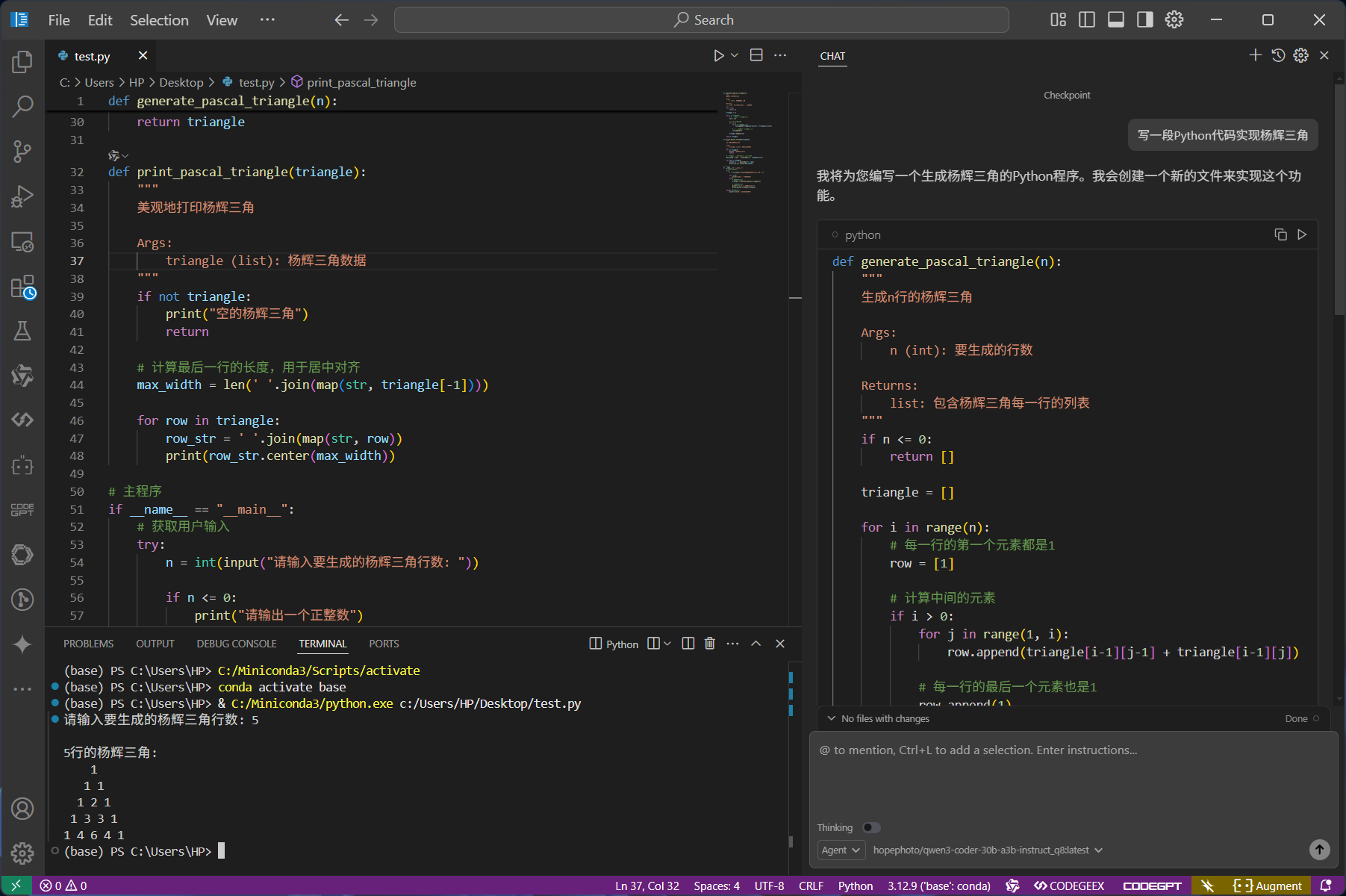

进入主界面之后,右侧的类似Cursor的对话区域就可以选择前面的那些模型了。

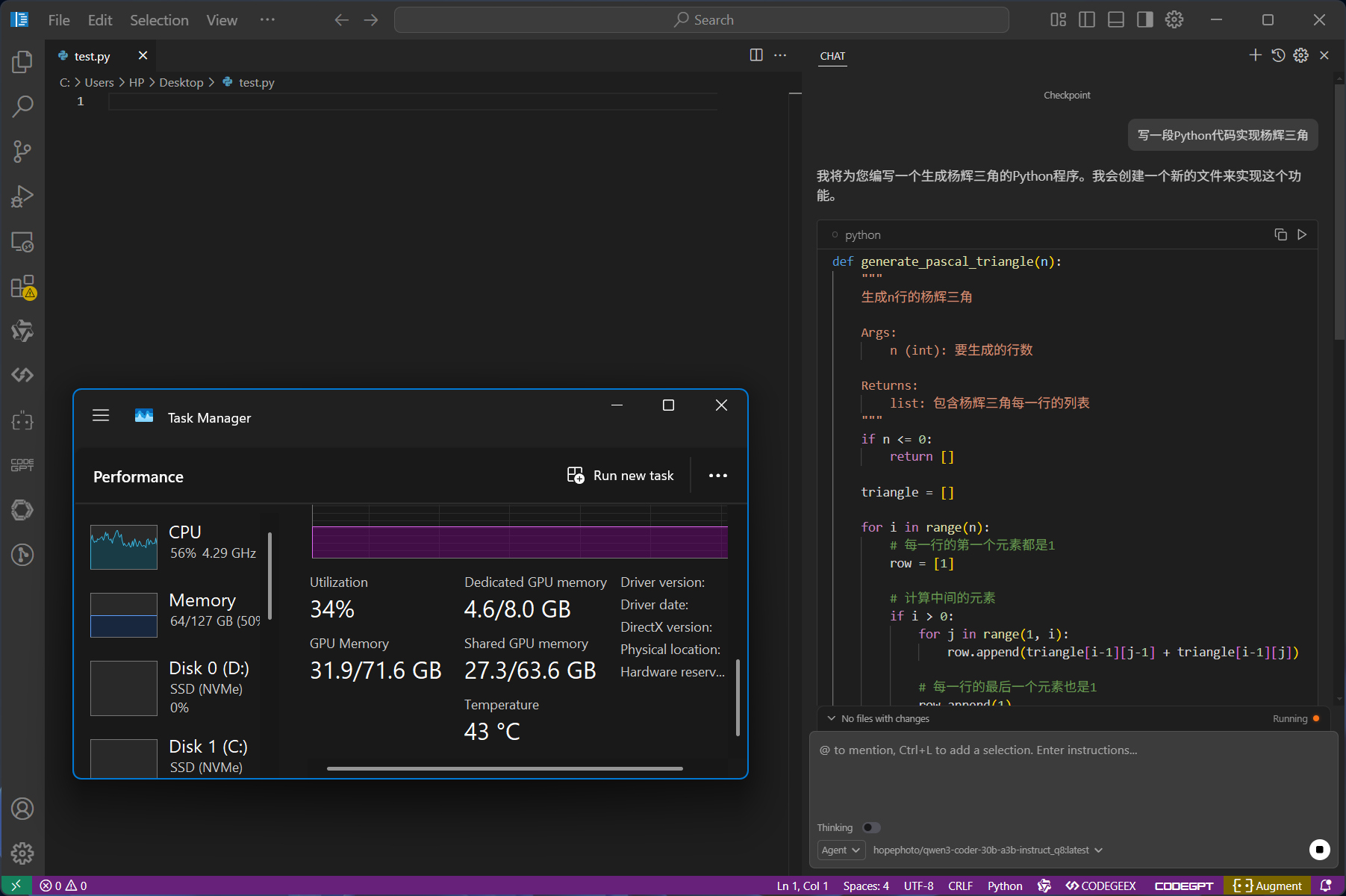

我这里选择的是本地部署的qwen3-coder-30b-a3b_q8,用的是我自己量化转换的版本,获取方式如下:

ollama run hopephoto/qwen3-coder-30b-a3b-instruct_q8

我这个版本占用存储空间比较大,要30G左右,然后运行起来的显存+内存占用也会超过32G,在64G内存+8G显存的机器上基本都能运行,4060 8G显存版本的笔记本显卡可以达到4-5 tokens/s的运行速度。

生成了一份杨辉三角的python代码,运行起来效果没问题,美滋滋。

CycleUser

CycleUser